Článek

Skupina vývojářů Facebooku odhalila „masivní chybu v algoritmu pro řazení příspěvků“. Tento program určuje, který obsah se uživatelům zobrazí na jejich domovské stránce (tzv. newsfeed) a jaké bude jejich pořadí. Čím důležitější příspěvek je, nebo čím je pro daného uživatele zajímavější, tím výše by se měl umístit.

Některé příspěvky – konkrétně ty, které nejsou proti pravidlům, ale jsou tzv. „na hraně“ – Facebook od roku 2016 úmyslně upozaďuje. To znamená, že je algoritmus ukazuje níže, než by je normálně ukázal, a tím snižuje jejich dosah. V říjnu 2021 si ale vývojáři Facebooku všimli rychlého šíření dezinformací, a to navzdory tomu, že byly tyto dezinformace označeny nezávislými ověřovači.

Jak později zjistili, mohla za to chyba algoritmu. Místo toho, aby dosah takovýchto příspěvků omezoval, naopak jej zvyšoval. S informací přišel 31. března server The Verge, který cituje informace z interní zprávy společnosti Facebook. V tu dobu již byla chyba opravená.

Mluvčí firmy Meta, která vlastní a provozuje síť Facebook, tento incident magazínu Verge potvrdil s tím, že dopady nebyly nijak významné: „Facebook při pěti různých příležitostech zjistil nesrovnalosti v „downrankingu“ (snižováním důležitosti příspěvku, pozn. red.), které korelovaly s malým, dočasným zvýšením interních metrik. Vypátrali jsme hlavní příčinu v chybě softwaru a provedli potřebné opravy. Tato chyba neměla žádný významný a dlouhodobý dopad na naše metriky.“

„The Verge tuto chybu značně nadhodnotil, protože v konečném důsledku neměla žádný významný a dlouhodobý dopad na problematický obsah,“ zaslala pro SZ Byznys mluvčí Facebooku podrobnější vyjádření. „Vždy byl ovlivněn jen velmi malý počet zobrazení obsahu ve feedu, protože drtivá většina příspěvků ve feedu vůbec nemá nárok na snížení hodnocení. Po zjištění nesrovnalostí jsme našli hlavní příčinu a rychle jsme aplikovali opravy. I bez oprav zůstalo v platnosti množství dalších mechanismů, které máme k dispozici, abychom zabránili lidem vidět škodlivý obsah.“

Interní zpráva naopak mluví o tom, že některé příspěvky získaly díky chybě i o 30 % větší dosah v globálním měřítku, což nezní jako nevýznamný dopad.

Odstranit, omezit, informovat

Sociální síť Facebook si zakládá na tom, že její pravidla jsou od roku 2018 veřejná a platí pro všechny stejně (až na kontroverzní výjimky). V takzvaných Zásadách komunity jsou uvedeny obecné i velmi konkrétní postupy, podle kterých moderátoři obsahu posuzují, zda je příspěvek či komentář možné na síti zveřejnit.

Zakázány jsou například výzvy k násilí (s nedávnými výjimkami), neautentické a falešné profily, šikana, odkazy na nebezpečné stránky, zobrazení nahoty v sexuálním kontextu, sexualizace dětí, zveřejňování cizích soukromých údajů nebo spam.

Zásady komunity sociální sítě Facebook

Ne vždy je ale rozhodnutí jednoznačné. Například lidé v dobré víře sdílí článek, který je ale později označen za zavádějící, protože v něm chybí důležitý kontext. V takových „hraničních“ případech může Facebook přistoupit k takzvanému omezení dosahu.

Ukázky obrazovek, kterými Facebook uživatele upozorní na nevhodný nebo pochybný obsah.

„Od roku 2016 používáme ke správě obsahu v technologiích Meta strategii nazvanou odstranit, omezit, informovat,“ popisuje Meta na svých stránkách věnovaných transparentnímu chování. „To znamená, že odstraňujeme škodlivý obsah, který je v rozporu s našimi zásadami. Omezujeme šíření problematického obsahu, který naše zásady neporušuje. A informujeme lidi pomocí souvisejících informací, aby se mohli rozhodnout, na co kliknout, co číst nebo sdílet.“

Kritici varují před skrytými algoritmy

Jenže namísto omezení dosahu algoritmus mohl kvůli programátorskému přehlédnutí naopak zvýšit dosah těmto „pochybným“ nebo „hraničním“ příspěvkům. Podle The Verge se to týkalo například „nahoty, násilí nebo i dezinformací ze státních ruských zdrojů“.

Aktuálně probíraná chyba znovu otevřela dlouhodobou diskuzi o tom, jaký vliv mají sociální sítě jako Facebook nebo Instagram na veřejnou i soukromou komunikaci. Debatu na podzim 2021 posílila whistleblowerka Frances Haugenová, která z Facebooku vynesla velké množství interních dokumentů.

Z nich mimo jiné vyplynulo, že Facebook má dlouhodobé problémy s moderováním obsahu, a to především v jazyku jiném než angličtině. Ukázalo se také, že Facebook dlouho nedokázal účinně zakročit proti obchodování s lidmi nebo proti šířícím se výzvám k násilí. Algoritmy také podle některých citovaných vývojářů Facebooku kladou příliš velký důraz na negativitu. „Zášť a hněv získávají pozornost. Rozhodně to není výsledek, který bychom chtěli.“ Autoři interní studie to přirovnali k fastfoodu, u kterého jej také lidé konzumují ve velkém množství, přestože jim škodí.

Vyjádření whistleblowerky Frances Haugenové

(4. října 2021 pro Senát USA – PDF)

Jmenuji se Frances Haugenová. Pracovala jsem ve Facebooku a přidala jsem se k němu, protože si myslím, že Facebook má potenciál probudit v nás to nejlepší. Ale dnes jsem tady, protože věřím, že produkty Facebooku škodí dětem, podněcují rozkoly a oslabují naši demokracii. A mnoho dalšího.

Vedení společnosti zná způsoby, jak Facebook a Instagram udělat bezpečnějším, ale potřebné změny neudělá. Dalo přednost svým vlastním zájmům. Upřednostňuje své obrovské zisky před lidmi.

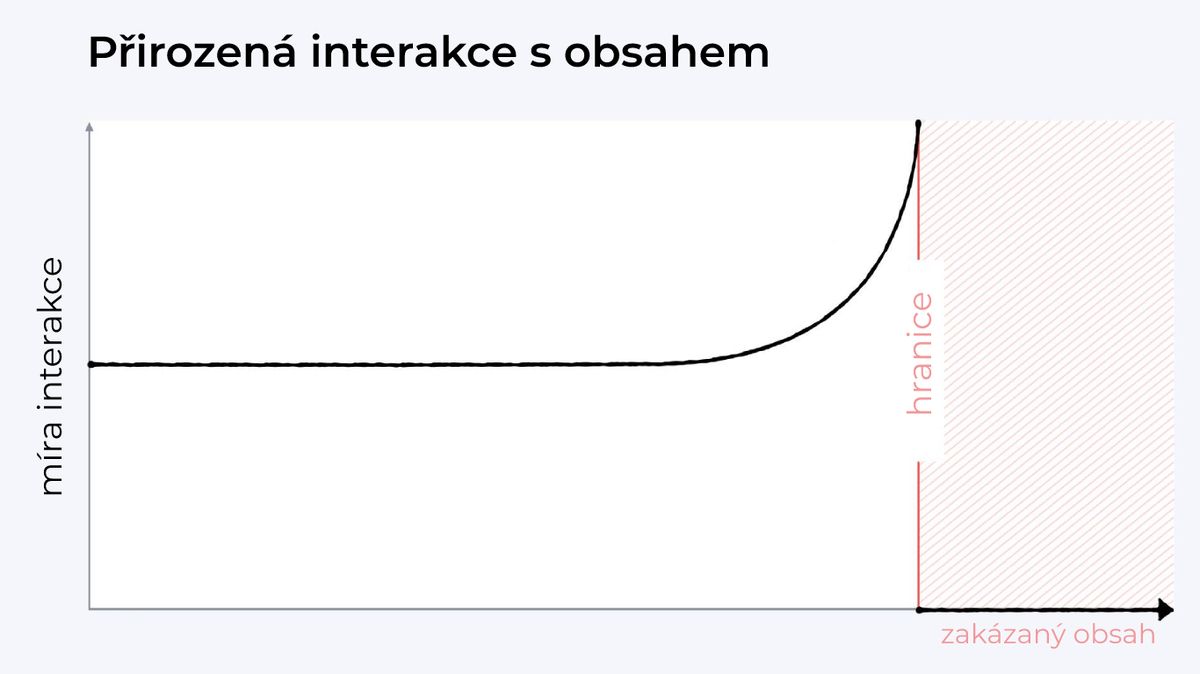

Současný incident jistě obnoví diskuzi o tom, jakým způsobem neviditelné (a veřejnosti nepřístupné) algoritmy ovlivňují, o čem se lidé na internetu baví a jak. Právě nenápadné omezování dosahu některých příspěvků, tzv. shadow ban, tedy stínový zákaz, patří k velmi kontroverzním. Mark Zuckerberg jej v roce 2018 obhajoval tím, že jinak se lidé snaží jít co nejblíže k hranici povoleného a tím dodávat svému obsahu provokativnost: „Z našeho výzkumu vyplývá, že bez ohledu na to, kde stanovíme hranici povoleného obsahu, jakmile se k ní obsah přiblíží, lidé se do něj v průměru zapojí více – i když nám poté řeknou, že se jim obsah nelíbí.“

Atraktivita obsahu podle Zuckerberga stoupá s tím, jak se blíží k „zakázané hranici“.

„Jedná se o základní motivační problém, který můžeme řešit penalizací hraničního obsahu,“ pokračoval Zuckerberg. Hraniční obsah tedy dostává na Facebooku penalizaci, aniž by byl přímo zakázán. Tím se podle Zuckerberga vyrovnává distribuční křivka: „S tím, jak se obsah stává senzačnějším, budou lidé odrazováni od vytváření provokativního obsahu, který je co nejblíže hranici.“

Kritici ale upozorňují na to, že netransparentní opatření není možné zkontrolovat a tím pádem ani studovat jeho dopady. „Data a transparentnost k tomu prostě nejsou k dispozici,“ varuje například David Lauer z organizace Urvin AI. „Facebook nepraktikuje transparentnost – nezpřístupňuje komplexní údaje o svých řadicích a filtračních algoritmech ani o dalších implementacích umělé inteligence.“ Aktuální incident – bez ohledu na skutečný rozsah – v tomto dává kritikům za pravdu. Kdyby byly algoritmy transparentní, možná by v nich taková zjevná chyba půl roku nevydržela.